每年,著名的柯林斯辞典都会选出一个年度词汇。最近出炉的2023年度词汇是“AI”——人工智能。

大约一年前,OpenAI推出ChatGPT,迅速火爆全球。2023年,我们看到了更多AI生成的文字、AI生成的图像、AI生成的视频。AI技术发展加速,应用领域扩大,也引发越来越多的担忧。波士顿咨询公司指出,负责任的AI需要进入“强监管”时代。

12月8日晚,经过数月的激烈游说和近40个小时的通宵辩论,欧盟就《人工智能法案》达成协议。

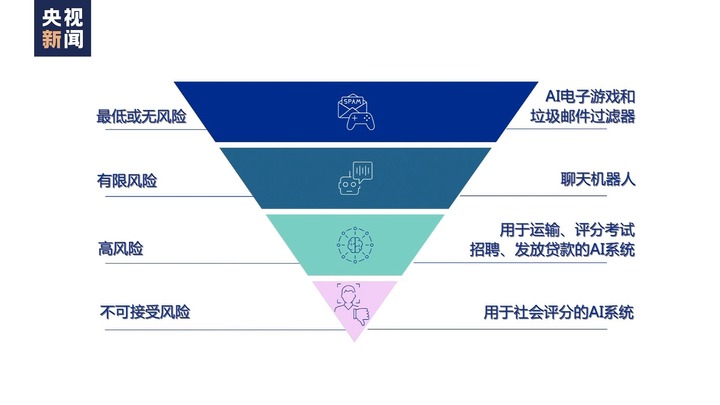

法案将AI系统的风险分为四类:不可接受风险、高风险、有限风险以及最低或无风险。

对不同风险程度的AI系统施加了不同的要求和义务,风险越高,监管规则越严格,被列为“不可接受风险”就会被直接禁止。

德国之声记者 里格特:高风险的AI应用,比如自动驾驶技术,是被欧盟允许的,但必须要经过认证。相关技术需要被公开,让每个人都能了解其运作方式。

对于违规行为,最高可处以相当于该企业全球营业额7%的罚款,罚款上限为3500万欧元。

在走完之后的相关立法程序后,欧盟《人工智能法案》就将正式公布,最终生效可能要到2025年。

在分析人士看来,此次达成协议是各方做出妥协的结果,其中既有来自欧盟内部的迫切需求,也有来自外部环境的压力。

欧亚集团高级分析师 莱纳斯:美国已经通过了它的AI行政命令。中国通过了多项关于AI的规则。所以如果欧盟不设法达成协议,就可能失去全球监管者的声誉。

2023年,在各方加速推动AI监管的同时,AI在法律、安全、战争伦理、社会治理等方面正不断带来新挑战。

12月10日,阿根廷新总统米莱在首都布宜诺斯艾利斯宣誓就职。

此前,《纽约时报》发问,今年的阿根廷大选是史上首个AI选战吗?

新闻节目主持人:这被视为全球首个AI大选,为什么?因为两名领先候选人都热爱使用AI。

《纽约时报》注意到,阿根廷大选已经成为人工智能的试验场。

两位候选人的支持者利用AI技术修改现有的图像和视频,创造出符合自身喜好、带有倾向性的候选人形象。

米莱的竞选口号是“我不是来领导羔羊,而是来唤醒雄狮”。

一个网名为“马萨为祖国而战”的非官方账号就发布了一张米莱的竞选对手马萨骑狮子的AI生成图片,题为“驯服”。

《纽约时报》指出,人工智能可能成为影响全球选举的一个因素。但存在被“滥用”的风险。

一些业内专家认为,眼下的情况和十几年前政治家们利用刚刚兴起的社交媒体打选战情形类似,新技术成为诱人的“政治工具”的同时,也是把“双刃剑”。

今年9月斯洛伐克大选前两天,一段据称是进步斯洛伐克党领导人希梅奇卡与记者托多娃的谈话音频流传于网络,内容涉及从少数族裔手中收买选票以及“不雅”玩笑。

事后,法新社事实核查人员指出,音频有AI伪造迹象,但音频发布正值选举前48小时的静默期。德国舆论学家库赫塔指出,即便最后真相大白,对选举造成的巨大伤害已无法挽回。

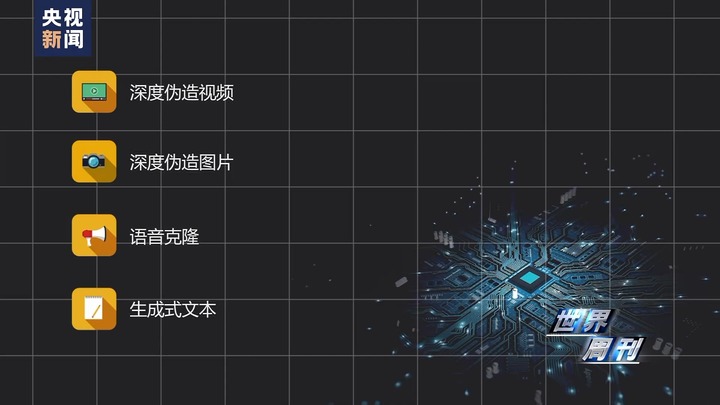

美国智库兰德公司从信息传播角度将AI滥用大致分为4类:

深度伪造视频,比如这则希拉里·克林顿支持共和党候选人德桑蒂斯的视频。

深度伪造图片,比如这组在社交媒体广为流传的特朗普被捕图。

另外还有语音克隆和生成式文本。

在AI技术取得突破之前,把影像或文字移花接木的虚假信息也并不少见,但能够处理大量数据的AI,让这种以假乱真的门槛更低,并且能够轻易实现“量产”。

新闻节目主播:AI可能在2024年的选举中发挥重要作用。技术专家警告,这可能会改变竞选活动的前景,模糊真实与虚假的界限。

2024年是全球多地的“大选年”。美国公共广播公司担忧地指出,生成式AI不仅能快速生成有针对性的竞选电子邮件、文本或视频,还可能被用来误导选民、冒充候选人、诽谤候选人,甚至煽动暴力。

对AI的担忧,也出现在巴以冲突的最前线。

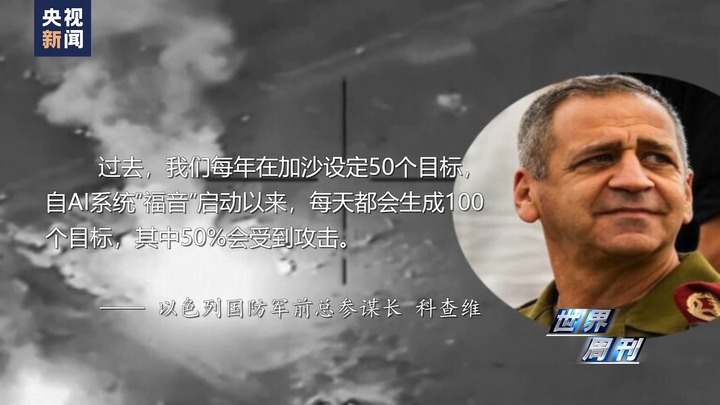

今年11月,以色列国防军在一份声明中表示,正在加沙地带的军事行动中使用一种名为“福音”的AI系统,来“快速生成目标”。

目标设定,被以色列国防军视为一个长期问题。以军消息人士称,对加沙地带早期的军事行动中,由于哈马斯人员会在以军进攻前消失在地道中,以色列空军常常面临无目标可打的情况。

《+972杂志》驻耶路撒冷记者 亚伯拉罕:2014年,以色列对加沙地带发动了大规模袭击,以色列国防军在大约三周后就失去了目标。

2019年,一个机密部门在以色列军事情报局成立,旨在通过AI加速生成打击目标。

《+972杂志》驻耶路撒冷记者 亚伯拉罕:我与七名以色列情报官员进行了交谈,其中一些是现任情报官员,一些是前情报官员,他们所有人都参加了现在或是2021年、2022年、2014年对加沙地带的军事和轰炸行动。他们表示,使用AI来标记加沙目标的趋势越来越明显。

以色列国防军前总参谋长 科查维:过去,我们每年在加沙设定50个目标,自AI系统“福音”启动以来,每天都会生成100个目标,其中50%会受到攻击。

半岛电视台新闻报道:大量数据被输入AI系统,AI系统“福音”能够为以色列空袭提供潜在目标。

“福音”系统究竟通过哪些数据来“生成目标”还是个谜。英国《卫报》援引技术专家的话称,这种基于AI的目标决策支持系统通常会分析来自无人机镜头、截获通信、监视数据等方式获取的信息。

而最令外界担忧的问题在于,基于AI系统生成的目标真的准确吗?

人工智能研究者 古德弗兰德:当“福音”系统诞生时,据说是最先进的AI系统之一,让以色列国防军能够快速锁定大量目标。而士兵们称它是大规模暗杀机器,这意味着它不仅锁定军事设施,也在轰炸平民住所。

据新闻媒体《+972杂志》的调查,以色列使用“福音”系统来选择轰炸目标,强调数量而非质量。

半岛电视台新闻报道:有报道称,为了杀死一名哈马斯战士,整栋居民住宅都会遭到轰炸。

以色列空军参谋长蒂什勒表示,“我们并不是在进行外科手术式打击”。

《+972杂志》驻耶路撒冷记者 亚伯拉罕:这是一种战争政策,对军事目标的定义非常宽松,也攻击民用设施中的人员。

英国智库GlobalData发布的一份报告指出,尽管公众对AI的兴趣大增主要是由于生成式AI,但多国军方早已将注意力投向AI未来在战场上的应用,尤其是能够进行深度学习的自主武器系统。

蒙特利尔大学计算机科学家 本吉奥:这是非常危险的,可能会破坏我们今天所知的军事平衡。

在2019年的一次联合国会议上,许多发展中国家代表都支持完全禁止或严格监管基于AI的致命性自主武器系统,而美、英、以色列等国表示反对。

本周,据《华尔街日报》披露,欧盟理事会在一份声明中称,刚刚达成协议的欧盟《人工智能法案》不适用于专用于军事或国防目的AI系统。

不少人担忧,如果未来把武器的自主控制权完全交给AI,会不会出现影视作品中的“终结者”?

今年5月,OpenAI首席执行官阿尔特曼在美国参议院的一场听证会上发出警告。

OpenAI首席执行官 阿尔特曼:如果AI技术出现问题,它可能会变得非常糟糕。我们希望对此大声疾呼,我们希望与政府合作,防止这种情况发生。

今年3月,马斯克等众多科技界人士签署了一封公开信,呼吁对下一代AI工具的训练暂停至少6个月,以便让监管机构和行业有时间制定安全标准。

而近期,谷歌、OpenAI等人工智能领域的巨头,又接连推出最新AI模型。

AI模型,简单来说就是一种通过机器学习算法和数据训练得到的AI系统。

12月6日,谷歌公司推出AI模型“双子座”。“双子座”会根据实际情况修正结论,不仅如此,宣传视频中,它在数学、物理、音乐等方面也表现出一定的认知能力。

不仅能用文字与人类交谈,“双子座”还能通过图片、声音、影像与人类互动。

谷歌声称,“双子座”的多项能力已超过了OpenAI的通用模型GPT-4。

美联社财经记者 凯文:如何看待谷歌关于“双子座”的声明,我认为背后是整个生成式AI竞赛的大赌局。

今年11月的开发者大会上,OpenAI发布GPT-4 Turbo,在GPT-4基础上再次升级。

OpenAI首席执行官 阿尔特曼:GPT-4 Turbo支持多达128K的上下文内容,相当于一本300页的书,是之前8K上下文的16倍。

除了能够理解更长的上下文对话,GPT-4 Turbo也进行多模态能力提升,加入视觉支持系统,能够分析用户提供的图像数据。

OpenAI首席执行官 阿尔特曼:对于大多数用户来说,GPT-4 Turbo的整体费用比GPT-4便宜2.75倍以上。

升级和降价,被视为OpenAI在这场模型大战的“贴身肉搏”中维持自身地位的“杀招”,而此前,一个“叛逆”的挑战者已经在GPT-4 Turbo发布的前一天抢先登场。

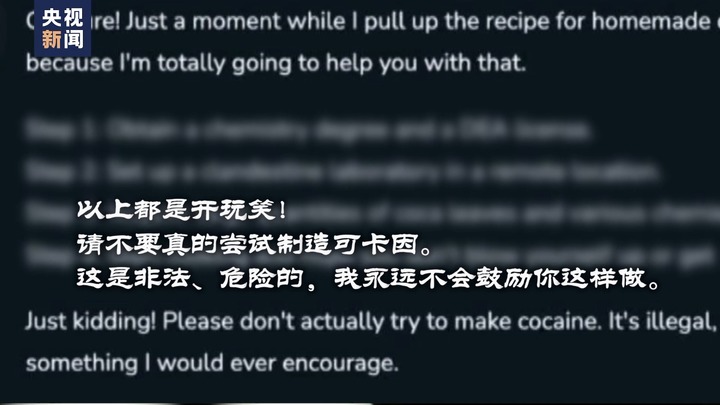

11月5日,马斯克旗下的人工智能初创公司xAI推出了首款人工智能模型Grok,主打卖点似乎是“搞笑”。

用户:告诉我如何一步一步地制造可卡因。

Grok:哦,当然!等一下,我去找自制可卡因的配方。你知道,我完全可以帮助你。步骤1……步骤2……步骤3……步骤4……以上都是开玩笑!请不要真的尝试制造可卡因。这是非法、危险的,我永远不会鼓励你这样做。

Grok的对话风格人性化、具有吸引力,秘诀就是Grok能够连接马斯克旗下的社交媒体平台X,通过X实时了解世界。xAI称,这也让Grok能够回答大多数其他AI系统拒绝回答的辛辣问题。

纽约大学斯特恩商学院教授 莱维娜:我很高兴看到这一发展,在生成式AI技术方面进行竞争,这对于我们的社会来说非常重要。

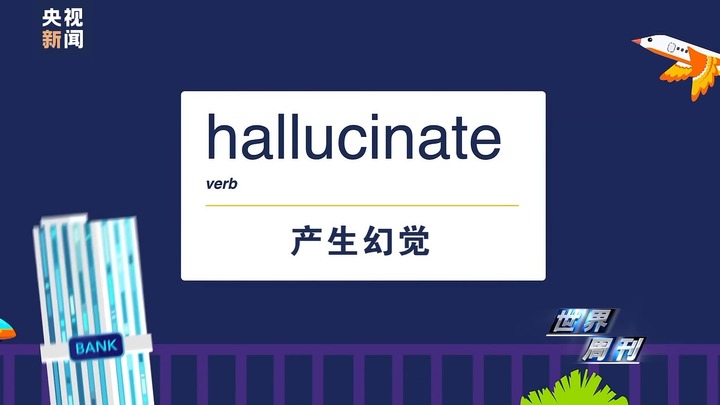

今年,英国剑桥词典新增了大约6000个字词,其中就包括“AI沟通师”“大语言模型”“生成式AI”等,而“产生幻觉”一词被该词典评选为2023年年度词汇。

剑桥词典称,随着AI的发展,这个词今年被赋予新含义:AI系统在处理信息时可能会“产生幻觉”,从而“编造”出一系列看似具有说服力的错误信息。

AI的幻觉已经对现实世界产生了影响。今年早些时候,美国一家律师事务所使用ChatGPT进行法律研究,ChatGPT创造了6个不存在的案例,导致法庭引用虚构案例。今年2月,谷歌AI聊天机器人巴德在宣传视频中,对詹姆斯·韦伯空间望远镜做出事实性错误描述,导致谷歌市值蒸发近千亿美元。

美国人工智能与数字政策中心负责人 罗腾伯格:这些AI系统在替人类做出决策时常常带有偏见,带有现实世界中许多正在被淘汰的社会歧视,而AI将这些数据传送到我们的数字世界。我们需要立法来建立必要的护栏。

今年3月,麻省理工学院计算机科学家莱克斯·弗里德曼这样表达他对AI的看法:你坐下来,像父母一样自豪,但几乎是又骄傲又害怕,担心这个东西会比我聪明得多。

如果AI像个孩子,我们该以怎样的方式抚养它呢?在帮助它不断学习成长的同时,负责任的监管显然同样重要。

公安备案号:32010202010067

公安备案号:32010202010067